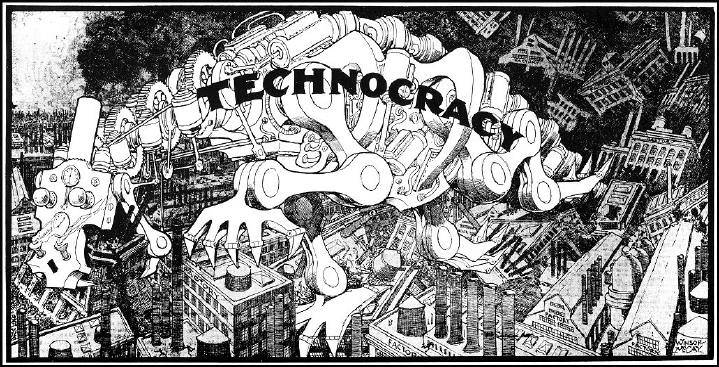

Wiadomości i trendy dotyczące technokracji Usługi premium są przeznaczone wyłącznie dla członków z dostępem premium. Sprawdź to!

Podobne artykuły: